UMICH CV Image Classification—KNN

在本节课中,首先justin老师为我们介绍了图像分类了基础概念以及其用途,这里就不多涉及了

接着我们思考图像分类问题,如果我们想要直接通过某种算法来实现图像分类,显然是比较棘手的,于是引入了机器学习的思想,即用数据驱动,用数据去训练我们的分类器,再用新的图像来评估我们分类器的性能

然后介绍了几个常见的用于图像分类的数据集,比如说MINIST,CIFAR100,CIFAR10,IMAGENET,Place365等等

接下来介绍了图形分类中一种常用的算法,也是我们作业中要去完成的算法即Nearest Neighbor Classifier以及k-Nearest Neighbor Classifier

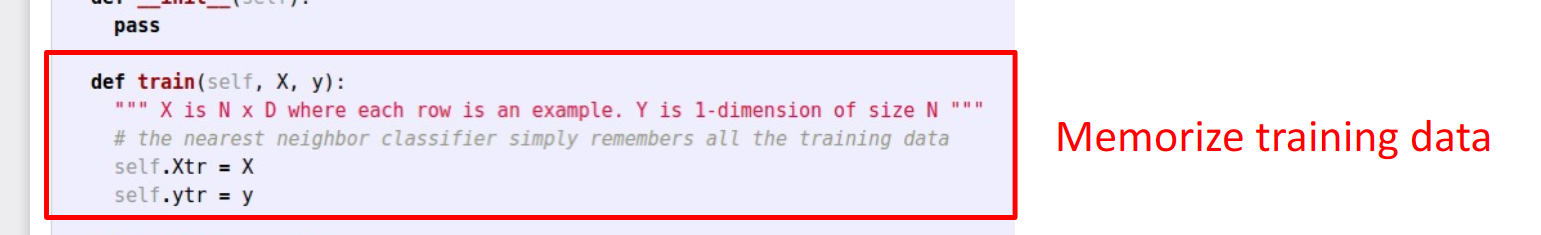

总体来说,我们大致需要两步来完成这个算法:

![图片[1]-umich cv-1 - 玄机博客-玄机博客](https://img2023.cnblogs.com/blog/3261639/202309/3261639-20230921193419736-539653469.png)

![图片[2]-umich cv-1 - 玄机博客-玄机博客](https://img2023.cnblogs.com/blog/3261639/202309/3261639-20230921193437548-1121102400.png)

即第一步只是简单的记忆来完成我们的训练过程,第二步选择综合起来离预测图像最近的图像的label,作为我们的预测值

但是我们也可以发现这类方法的致命问题,那就是它的训练时间要比预测时间短,即我们可能很快就可以完成我们模型的训练,但是想要得出我们预测的结果需要很长时间,而这恰好与我们的理念是背道而驰的,我们不在乎要多少时间来训练,而想要尽快的得到预测结果

同时在执行此类算法时,有两个参数很重要,一个是k值的选择,即我们要综合考虑几个周围的邻居的距离来做出判断,一个是我们要选择什么来作为距离的衡量方式

![图片[3]-umich cv-1 - 玄机博客-玄机博客](https://img2023.cnblogs.com/blog/3261639/202309/3261639-20230923171124254-495014774.png)

从上面这两张图可以看出k值与距离公式的选择,对于分类尤其是决策边界有着一定程度的影响

因此,如何选择最合适的k值与距离公式,对于knn模型来说,是一个非常重要的问题

用更专业更普适的说法,就是如何去选择我们模型的超参数:

接下来就是讨论如何去设置超参数

![图片[4]-umich cv-1 - 玄机博客-玄机博客](https://img2023.cnblogs.com/blog/3261639/202309/3261639-20230923171627126-2131028159.png)

首先第一种也是最直接的想法,我们只需要挑选在我们的数据集上表现最好的超参数

这种想法的问题就是会导致模型只在我们训练的数据上表现好,一遇到新的数据表现就不行

第二种就是将数据划分为训练集与测试集,找出在测试集上表现最好的超参数,但是这种想法和第一种也是相同的问题,我们的测试集数据会对模型对超参数的判断产生一定的污染,因而在新的数据上表现也不佳

第三种就是我们划分成train,validation与test三个数据集,用validation找出超参数,在test上测试,而这种的问题在于我们的test只能用一次,就是在找出超参数之后作为新数据测试,而如果我们经过很长的时间研究算法,调整参数最后去测试发现效果不好,一切都前功尽弃了,所以这种方法实用性也不高

最好的方法就是采用交叉验证

![图片[5]-umich cv-1 - 玄机博客-玄机博客](https://img2023.cnblogs.com/blog/3261639/202309/3261639-20230923172454554-1269525436.png)

把数据集划分成不同的fold,每个fold依次扮演validation或者test或者train的角色

但是缺点也很明显,当数据量增大时,这种花费的时间显然非常久,我们可以将这种方法应用于小数据集

最后对knn算法的用途进行了讨论

![图片[6]-umich cv-1 - 玄机博客-玄机博客](https://img2023.cnblogs.com/blog/3261639/202309/3261639-20230923172724035-189611002.png)

除了我们之前提到的,knn算法的预测时间复杂度问题,其简单地使用距离公式来进行分类,有时也会产生错误,比如上面这张图,下方的四个图片的距离值都是一样的,但是显然它们有着巨大的差别

所以直接使用knn算法显然是一个不好的选择,但是我们可以在某些模型的某些步骤去应用knn算法

![图片[7]-umich cv-1 - 玄机博客-玄机博客](https://img2023.cnblogs.com/blog/3261639/202309/3261639-20230923184730190-1396351970.png)

如上图所示,我们在ConvNet中对不同图片的特征向量使用knn进行分类,早最终的图片分类效果较好

最后放一张总结图:

ps:本次A1的作业比较简单,主要引导学生初步学习pytorch,在knn实现中,强调了向量化编程的重要性,减少循环的使用,最后使用交叉验证来寻找k值,这里就不再详细介绍具体实现。

1.本站内容仅供参考,不作为任何法律依据。用户在使用本站内容时,应自行判断其真实性、准确性和完整性,并承担相应风险。

2.本站部分内容来源于互联网,仅用于交流学习研究知识,若侵犯了您的合法权益,请及时邮件或站内私信与本站联系,我们将尽快予以处理。

3.本文采用知识共享 署名4.0国际许可协议 [BY-NC-SA] 进行授权

4.根据《计算机软件保护条例》第十七条规定“为了学习和研究软件内含的设计思想和原理,通过安装、显示、传输或者存储软件等方式使用软件的,可以不经软件著作权人许可,不向其支付报酬。”您需知晓本站所有内容资源均来源于网络,仅供用户交流学习与研究使用,版权归属原版权方所有,版权争议与本站无关,用户本人下载后不能用作商业或非法用途,需在24个小时之内从您的电脑中彻底删除上述内容,否则后果均由用户承担责任;如果您访问和下载此文件,表示您同意只将此文件用于参考、学习而非其他用途,否则一切后果请您自行承担,如果您喜欢该程序,请支持正版软件,购买注册,得到更好的正版服务。

5.本站是非经营性个人站点,所有软件信息均来自网络,所有资源仅供学习参考研究目的,并不贩卖软件,不存在任何商业目的及用途

暂无评论内容